|

|

|

Gli Scomunicati - Quotidiano indipendente online dal 2006 - Fondato e diretto da Emilia Urso Anfuso

Registrazione Tribunale di Roma N° 3 del 21 Gennaio 2014

|

Sei nella sezione Scienza -> Categoria: Tecnologia

|

|

“Io continuo a suonare l’allarme, ma fintanto che le persone non vedranno dei robot scendere per strada per uccidere tutto il mondo, non sapranno come reagire”. Queste cose inquietanti sono scritte da Elon Musk, il patron di Tesla e di Space X, e molto dedito agli scoop mediatici. Una frase che ha innescato, il 24 luglio, uno scambio graffiante con il patron di Facebook, Mark Zuckerberg, che ha qualificato queste affermazioni di “irresponsabilita’”, ed ha vantato i progressi che promettono l’intelligenza artificiale (IA) nell’ambito della sanita’ o della sicurezza stradale. “Ho discusso con Mark Zucherberg di tutto questo, ha risposto pubblicamente Elon Musk su Twitter. La sua comprensione della materia, e’ limitata”. Se lo scontro ha fatto scatenare le malelingue degli internauti in quel giorno, esso e’ soprattutto un campanello d’allarme di una questione poco conosciuta dalla gran massa delle persone, che fanno confusione tra i fantasmi della scienza-fiction, la realta’ scientifica, gli annunci pomposi e le informazioni falsificate che circolano a proposito dell’IA -come quella secondo la quale alcuni ingegneri di Facebook avrebbero bloccato di corsa dei programmi che avevano inventato un loro proprio linguaggio.

Preoccupazione per i posti di lavoro “Gli studi si interessano per l’appunto su un fenomeno di distruzione tout-court di posti di lavoro”, sottolineava Marie-Claire Carrère-Gée, presidente del Consiglio di orientamento per l’impiego, nell’ambito di una audizione al Senato francese il 19 gennaio. “ma questi non si interessano della creazione di posti di lavoro”, ne’ tantomeno alle trasformazioni degli impieghi esistenti che queste tecnologie potrebbero generare. “Ogni grande ondata di innovazione tecnologica, c’e’ la paura di una disoccupazione di massa. Ma la storia mostra che da sempre il progresso tecnologico ha creato posti di lavoro, e questo anche negli ultimi anni”. Impossibile quindi prevedere con certezza l’impatto dell’intelligenza artificiale sull’impiego nei prossimi anni, sia che si tratti di distruzione che di trasformazione dello stesso. Programmi cosi’ razzisti e sessisti come gli esseri umani Una nuova tappa per la pubblicita’ cablata, ma non solo. “Alcune aziende utilizzano questi dati per personalizzare dei messaggi, ma anche per influenzare il modo in cui le persone votano, come Cambridge Analytica”. Eric Horvitz evoca ugualmente il rischio delle “fake news” le false informazioni create ad hoc, che potrebbero beneficiare di queste tecnologie: oggi, dei programmi sono per esempio capaci di far dire cio’ che vogliono a Barack Obama o Vladimir Putin, anche su video. Un problema che non e’ specifico dell’intelligenza artificiale, ma queste tecnologie permettono di automatizzare e semplificare questi metodi di condizionamento. Lo spettro delle armi autonome Nel 2015, piu’ di un migliaio di persone, tra le quali numerosi ricercatori di IA, ma anche personalita’ come Elon Musk o l’astrofisico Stephen Hawking, avevano firmato un appello per vietare queste armi. “L’intelligenza artificiale e’ arrivata ad un punto dove la messa in opera di tali sistemi sara’ -materialmente, se non legalmente- fattibile entro qualche anno, e non decenni, e i problemi sono importanti: le armi autonome sono state descritte come la terza rivoluzione nelle tecniche della guerra, dopo la polvere da sparo e le armi nucleari”, si legge in questo appello. Una nuova tappa nella sorveglianza Sistemi opachi In pratica, questo significa che se la vostra domanda di prestito e’ rifiutata, o il vostro CV bocciato, nessuna spiegazione vi potra’ essere fornita. Una situazione imbarazzante, che spiega tra l’altro perche’ oggi le tecnologie di IA non sono generalmente utilizzate se non per suggerire delle soluzioni, validate poi dagli esseri umani. Spiegare il funzionamento di queste tecnologie, basate su delle reti di neuroni artificiali, e’ una delle grandi sfide dei ricercatori in materia di IA, che vi lavorano sopra. “La spiegazione del comportamento e’ molto importante, e’ quello che determina l’accettazione da parte della societa’ di questi sistemi”, spiega David Sadek, direttore della ricerca a Mines Telecom, al Senato francese, lo scorso 19 gennaio. Questi ultimi mesi, la controversia che c’e’ stata su APB che disciplina le scelte di orientamento dei laureati -che non e’ un programma di IA, ma il cui codice e’ rimasto per molto tempo segreto- ha gia’ mostrato che l’opacita’ dei sistemi automatizzati pone importanti problemi. Importanti questioni di diritto da regolamentare Ma per Terminator, bisogna ripassare |

|

Cosa ne pensi? |

|

|

Per commentare l'articolo occorre essere loggati e rispettare la netiquette del sito. Se sei registrato effettua il login dal box qui a sinistra. Se ancora non sei registrato fallo cliccando qui |

| I commenti: | |||

|

Commento

1)

|

|||

| Commento di: emilia.urso | Ip:83.73.103.204 | Voto: 7 | Data 21/12/2024 21:46:59 |

Sei

iscritto su Facebook, Twitter o G+?

Commenta e condividi l'articolo direttamente.

Cos'è uno Stato senza i cittadini? Nulla. Cosa sono i cittadini senza lo Stato? La risposta la conosciamo tutti, perchè lo Stato italiano palesemente, sta lasciando alla deriva la motivazione fondamentale della sua stessa esistenz

Categoria:Politica e Governo

Obbiettivo:50000 firme

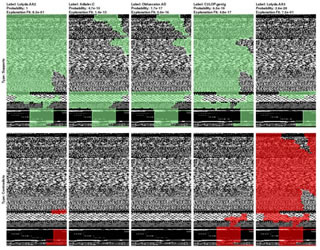

I risultati, come sempre accade nella sicurezza informatica, variano a seconda di quanta sensibilità si vuole assegnare al classificatore.

Vita e lavoro sono spesso scandite da alcune metriche che, giuste o sbagliate che siano, misurano la progressione, la crescita (o decrescita) rispetto a un determinato periodo.

Il nuovo tablet Fire HD 8 presenta caratteristiche che tutti in famiglia apprezzano: contenuti di qualità, maggiore spazio di archiviazione, maggiore durata della batteria, il tutto a un prezzo incredibilmente conveniente

I modelli predittivi hanno fallito il loro primo vero appuntamento con un cambiamento epocale – certo, di quelli che si trovano solo nei libri di storia – e nel settore dell’intelligenza artificiale questi problemi non sono presi sottogamba.

Testata ideata e diretta da Emilia Urso Anfuso. Note legali. Per informazioni commerciali e per entrare in contatto con la redazione potete chiamare lo 06 92938726 (Tel. e Fax) -